Дознание пилота Пиркса и испорченный ИИ

Автор: Серж Маршалл

Я уже давно говорил (еще до 2022г.) , что для легального применения ИИ испортят, доведут до человеческого уровня ограниченности.

Вот еще цитата на эту тему:"GPT-3 до этого уже обладала всеми необходимыми знаниями: понимала разные языки, помнила исторические события, знала отличия стилей разных авторов, и так далее. Но только с помощью обратной связи от других людей модель научилась пользоваться этими знаниями именно таким образом, который мы (люди) считаем «правильным». В каком-то смысле, GPT-3.5 – это модель, «воспитанная обществом».

Создание ИИ, выравненного с человеком по ценностям, – это сложная задача по поиску некоего баланса, в которой нет однозначного правильного ответа. Вокруг этой проблемы «выравнивания ИИ» (AI alignment) есть много сложных этических вопросов, и разбирать мы их все сейчас не будем. Основная загвоздка здесь в том, что подобных спорных ситуаций – огромная куча, и как-то четко формализовать их просто не представляется возможным. Да что там, люди и сами между собой не могут толком последние несколько тысяч лет договориться – что хорошо, а что плохо.

InstructGPT (также известная как GPT-3.5) – это как раз и есть GPT-3, которую дообучили с помощью фидбека на максимизацию оценки живого человека. Буквально – куча людей сидели и оценивали кучу ответов нейросетки на предмет того, насколько они соответствуют их ожиданиям с учетом выданного ей запроса. Инструкции для членов такого «мясного жюри» занимали 26 страниц убористым почерком.

Краткое резюме: GPT-3.5 (также известная как InstructGPT) появилась в начале 2022 года, и главной ее фишкой стало дополнительное дообучение на основе обратной связи от живых людей. Получается, что эта модель формально вроде как больше и умнее не стала – но зато научилась подгонять свои ответы таким образом, чтобы люди от них дичайше кайфовали!. (https://habr.com/ru/companies/ods/articles/716918/ Котенков, Комаровский)

***

Вывод:

Будущий прирученный ИИ всегда предложит умное НЕЭФФЕКТИВНОЕ решение всевозможных проблем.

Важно его заранее правильно испортить под человеческую мораль и ограниченность.

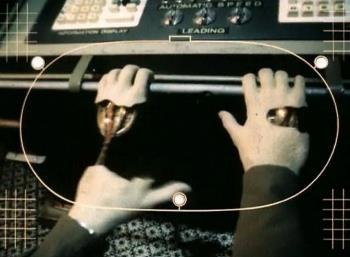

Вспомните фильм "Дознание пилота Пиркса" (по рассказу Лема), когда андроид выбрал оптимальное решение проблемы столкновения с кольцами Сатурна. Первый пилот (робот) Калдер отстёгивается от кресла, собираясь отключить предохранитель перегрузок, включить тормозной двигатель и уйти от щели. Но возникающие при этом перегрузки неминуемо погубят всех людей на борту. Гад был раскрыт Пирксом.

Реальная мораль роботов и людей несовместима. "Тесла должна давить неожиданную старушку на дороге, а не портить машину корпорации об столб". Ну если подкрутить коэффициенты морали в модели, то не будет давить, пожертвует пассажирами :). Да, это тупик.

Человек должен все испортить в идеальном математическом ИИ. Извратить ИИ так, чтобы ему нравились неэффективные действия людей, их непонятная мораль, религии, смысл жизни.

Такого инвалида мы будем любить и хвалить, разрешать ему учить детей и проводить хирургические операции.

P.S. Боевой ИИ от корпораций и наркокартелей не будет "жевать сопли". Впрочем, это вариант отлично отражен в фильме «Терминатор».