ИИ-доктор вас примет: Расшифровывая «сверхчеловеческий» прорыв в диагностике

Автор: Дибутил Фталат![]() За гранью ажиотажа: Новое исследование показывает, что ИИ превосходит врачей в медицинском мышлении. Но что это значит для вашего следующего визита к врачу?

За гранью ажиотажа: Новое исследование показывает, что ИИ превосходит врачей в медицинском мышлении. Но что это значит для вашего следующего визита к врачу?

Все мы бывали в такой ситуации – с тревогой ожидая диагноза врача, доверяя его многолетнему обучению и опыту. Но что, если алгоритм мог бы в некоторых критических аспектах сделать это даже лучше? Новая статья «Сверхчеловеческая производительность большой языковой модели в задачах врачебного мышления» (источник: https://arxiv.org/abs/2412.10849) только что вызвала бурление в медицинских и технологических кругах, предполагая, что эра диагностики с помощью ИИ, а возможно, и под руководством ИИ, наступит быстрее, чем они боялись.

Как человек, находящийся на стыке технологий и их реального применения, я нахожу эти разработки одновременно захватывающими и немного тревожными. Давайте разберемся, что на самом деле означает это исследование, как для технических специалистов, создающих эти системы, так и для каждого из нас, кто однажды может стать пациентом.

Как именно ИИ «перемудрил» врачей?

В исследовании передовые большие языковые модели (LLM), в частности версии серии «o1» от OpenAI, сопоставлялись с сотнями врачей в серии строгих тестов. Результаты были, мягко говоря, ошеломляющими. LLM не просто соответствовала человеческим показателям; она продемонстрировала «сверхчеловеческие диагностические и мыслительные способности».

Вот краткий обзор победной тактики ИИ:

- Решение сложных случаев (клинико-патологические конференции NEJM): Клинико-патологические конференции (КПК) Медицинского журнала Новой Англии (NEJM) – это общепризнанно сложные диагностические задачи, эталон с 1950-х годов. Модель «o1-preview» включала правильный диагноз в свой список в 78,3% случаев, а ее первое предположение было верным во впечатляющих 52% этих сложных случаев. Она также значительно превзошла более раннюю модель GPT-4. Когда дело дошло до предложения следующего диагностического теста, она была «абсолютно права» в 87,5% случаев.

- Безупречное клиническое мышление (NEJM Healer): В виртуальных случаях пациентов NEJM Healer, предназначенных для оценки клинического мышления, «o1-preview» достигла идеального результата по утвержденной 10-балльной шкале (R-IDEA) в 78 из 80 сценариев. Это значительно превзошло показатели GPT-4, практикующих врачей и ординаторов.

- Мастерство в управлении лечением (случаи Grey Matters): В сценариях, требующих принятия решений по ведению пациентов, «o1-preview» показала средний балл 86%, что намного опережает GPT-4 (42%) и врачей, даже когда у этих врачей был доступ к GPT-4 (41%) или традиционным ресурсам (34%).

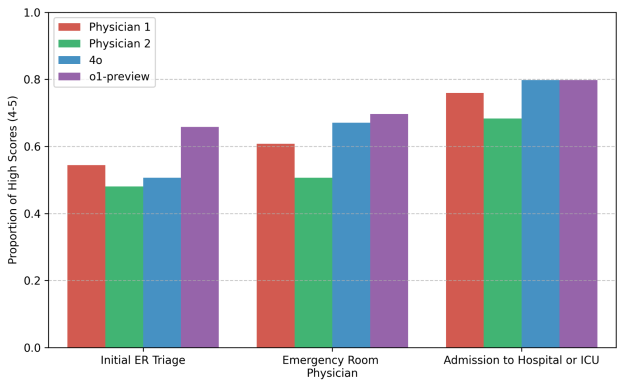

- Блестящие результаты в отделении неотложной помощи (реальные случаи): Возможно, наиболее поразительно то, что в реальном исследовании с использованием случайно отобранных случаев из отделения неотложной помощи модель «o1» предоставляла более точные вторые мнения, чем два лечащих врача и GPT-4o. Это оценивалось другими врачами, которые не знали, исходил ли диагноз от человека или ИИ.

Когда ИИ имеет преимущество?

Исследование показало, что преимущество ИИ было особенно заметно в ситуациях с высокой степенью риска и ограниченным объемом информации. Подумайте о первоначальной сортировке в отделении неотложной помощи: медсестра собирает предварительные данные, и быстрая, точная оценка имеет решающее значение. В этих ситуациях, когда информация скудна, а срочность высока, модель «o1» определила точный или очень близкий диагноз в 65,8% случаев, превзойдя своих человеческих коллег. По мере поступления дополнительной информации (например, оценка врача отделения неотложной помощи, госпитализация в отделение интенсивной терапии) и люди, и ИИ улучшали свои показатели, но LLM последовательно сохраняли лидерство.

Почему это так важно? Отрезвляющая цена ошибок

Последствия чудовищны. Диагностические ошибки и задержки влекут за собой «огромные человеческие и финансовые издержки». Они могут привести к ухудшению состояния, ненужному лечению и, трагически, к потере жизни. Более того, доступ к высококлассной медицинской диагностической экспертизе не является универсальным. Если ИИ сможет обеспечить диагностическую поддержку на уровне экспертов (или даже сверхчеловеческом уровне), это могло бы демократизировать доступ к высококачественному медицинскому мышлению, особенно в недостаточно обслуживаемых районах или в учреждениях общей практики.

Насколько «хорошо» – достаточно хорошо?

Есть старая история, которую часто используют для иллюстрации причуд экспертного прогнозирования. Звучит она примерно так: ученые со сложными глобальными данными могут предсказывать погоду на завтра лишь с 25% точностью. Местные мудрецы, полагаясь на традиционные приметы, могут достичь 50%. Но простое, «слепое» предсказание – что завтрашняя погода будет такой же, как сегодня – может оказаться верным на 75%.

Это не для того, чтобы высмеять метеорологов (или врачей!), а чтобы подчеркнуть, что даже устоявшиеся экспертные системы могут иметь удивительно скромные базовые показатели точности для сложных проблем. Если точность человеческой диагностики в некоторых сложных сценариях колеблется в определенном диапазоне, ИИ, который всякий раз превосходит этот диапазон, – это не просто улучшение; это потенциальная революция. Исследование предполагает, что LLM совершают этот скачок.

Вопрос на миллиард: Кто заплатит, когда ИИ ошибётся?

Здесь дорога становится ухабистой, особенно для специалистов по продажам и административного персонала, которым приходится ориентироваться в реальном внедрении таких технологий. Врачи и больницы, как правило, защищены слоями страхования, устоявшимися правовыми прецедентами и структурами корпоративной этики. Но ИИ? Если ИИ совершает диагностическую ошибку, кто несет ответственность? Разработчики ИИ? Компания, которая обучала модель? Больница, которая ее внедрила? Производитель оборудования?

Эта потенциальная «полная свобода ответственности» – серьезная проблема. Она может либо стимулировать инновации к беспрецедентному уровню безопасности и точности, либо, наоборот, задушить внедрение полезных технологий из-за страха судебных исков.

С моей точки зрения, здесь есть ещё и этическое соображение. Если ИИ может поставить диагноз, который даже на долю процента вероятнее спасет жизнь, чем традиционные методы, какое вообще может быть оправдание отказа от его использования или стремления врачей не соответствовать этому потенциально улучшенному базовому уровню? Правовая защита, предоставляемая человеческой ошибочности, не может стать препятствием для внедрения достижений, спасающих жизни.

Признавая оговорки: Критика и ограничения

Крайне важно подходить к этим выводам критически, как это делают и сами исследователи. У исследования есть ограничения:

- Оно в первую очередь оценивало производительность модели в изоляции, а не то, как люди и LLM могут эффективно сотрудничать.

- Оно исследовало лишь некоторые из многих аспектов клинического мышления.

- Основное внимание уделялось внутренним болезням и неотложной медицине, поэтому результаты могут не распространяться на все медицинские специальности, такие как хирургия.

- Задача в реальных условиях отделения неотложной помощи, хотя и убедительная, была подтверждением концепции для вторых мнений и не полностью отражала сложность принятия решений в отделении неотложной помощи (например, сортировка или определение дальнейшей тактики ведения пациента).

Сотрудничество, а не уничтожение: Путь вперед

Авторы не предполагают, что ИИ полностью заменит врачей. Вместо этого они призывают к «проспективным испытаниям для оценки этих технологий в реальных условиях оказания медицинской помощи пациентам» и исследованиям «взаимодействия человека с компьютером». Будущее, вероятно, связано с врачами, дополненными ИИ – мощным партнерством, использующим сильные стороны обоих. Представьте себе ИИ, неустанно просеивающий данные, отмечающий потенциальные диагнозы, вспоминающий малоизвестные состояния, в то время как врач-человек привносит эмпатию, контекстуальное понимание и окончательную ответственность за принятие решений.

Лично я считаю, что это самый многообещающий путь. Цель не в том, чтобы создать враждебные отношения между врачами и ИИ, а в том, чтобы создать инструменты, которые повышают стандарт медицинской помощи для всех. Вывод статьи о том, что LLM «реализовали видение, изложенное Ледли и Ластедом» в 1959 году – создать ИИ, способный овладеть сложным клиническим мышлением на примерах историй болезни, – является монументальным заявлением.

Путь еще далек от завершения. Нам нужны надежный мониторинг, этические принципы и продуманная интеграция в клинические рабочие процессы. Но это исследование знаменует собой явный поворотный момент. ИИ-доктор – это уже не просто научно-фантастический троп; это быстро развивающаяся реальность, которая обещает изменить медицину, какой мы ее знаем. И это то, что должно привлечь всеобщее внимание.