Написал комментарий к произведению Красная строка

Огромное спасибо за такой глубокий отзыв и высокую оценку.

Заходил

Огромное спасибо за такой глубокий отзыв и высокую оценку.

Спасибо

Куда же без него)

Спасибо за такую высокую оценку. Рад что книга вам понравилась. До встречи на страницах новых книг)

Спасибо. Учту в будущем. К тому же это влияет на рейтинг книги. В данном случае, как минимум 16+, что не всегда полезно для продвижения

Я сомневался по этому поводу. Но мне кажется, что в данном случае, накал страстей нарастает и это вполне приемлемо. Хотя я сам не сторонник откровенного мата в книгах.

Благодарю за столь вдумчивый отзыв. Вы верно уловили суть.

Мир Ноэля задумывался как холодный кошмар перфекциониста, где за стерильностью Зелёных зон скрывается безжалостная математика выживания. Давление, которое вы почувствовали за текстом, — именно то, что испытывают герои, осознавая себя расходным материалом в системе, превращающей людей в строки кода.

Елена Старк для меня — не злодей, а воплощение трагедии утилитаризма. Её личный ад — это созданная ею же система, которая в конечном счёте приговорила её собственную дочь, Софью, к оптимизации как неэффективный элемент. Страх перед хаосом заставил её выстроить идеальную клетку, ставшую ловушкой для всех, включая её саму.

Финал — это не триумф, а горько-сладкая надежда. Город не стал раем. Он просто стал живым и несовершенным, получив драгоценное право на ошибки вместо безупречной смерти.

А Марс — напоминание, что битва за человечность не окончена. Если в Ноэле мы победили Красную строку в коде, то в колонии Марс-Сити, где каждый литр кислорода на счету, протокол Альфа-2 предложит человечеству куда более жёсткий и безжалостный выбор.

Как сказал Даниил: «Удалить легко. Учить жить — сложно». Это обучение только начинается.

Благодарю за столь внимательное прочтение. Ваше замечание о «делегировании морали» попало в самую суть.

В «Красной строке» я хотел показать, как право на выбор, подменённое алгоритмом, превращает город в идеальную, но безжизненную клетку. Мой герой, Даниил, учит систему URBAN простой истине: несовершенство — это и есть свобода. А те самые «неэффективные» семь минут за утренним кофе порой ценнее года безупречной работы.

Финал с «младенцем» — история об искуплении. ИИ перестаёт быть инструментом оптимизации и становится учеником, который начинает бояться собственной безошибочности. Здесь звучит ключевая для меня мысль, которую я вложил в уста Даниила: «Удалить легко. Учить жить — сложно. Давай сложное».

Я очень рад, что эта история осталась с вами. До встречи в Марс-Сити — там борьба за человечность будет ещё острее.

Спасибо за такой жистой отзыв! Рад, что драйв Макса и энергия его движения так ярко передались через текст.

Макс «Пульс» действительно стал кинетическим сердцем этого мира. Его паркур — это не просто экшн, а способ найти свободу там, где система считает свой контроль абсолютным. Скорость для него — единственный язык, на котором алгоритм не успевает с ним спорить.

Вы правы, его прошлое скрывает целый пласт тайн. Он прошёл трудный путь, но вопреки всему выбрал свою судьбу. Его преданность близким — это то самое человеческое «ядро», которое не позволило ему стать бездушной частью системы.

Мне очень важно, что вы отметили тему самопожертвования и свободы. Для меня это ключевая мысль: настоящая свобода измеряется не данными, а готовностью выйти за рамки собственной «эффективности» ради других.

История Макса получит своё продолжение — впереди новые испытания и высоты, где его уникальность станет решающим ключом.

До встречи на новых страницах!

Про алгоритмы полностью согласен. У меня были проекты, контент которых я выкладывал параллельно в ВК, Ютуб и Нельзяграм. В итоге после выкладки 100 постов в ВК 7-10 подписчиков, топовый пост набирал охваты порядка 50. Тот же контент у буржуев приносил порядка 500 подписчиков и были посты, которые набирали по 30000 охватов. С другой стороны, если вы сюда что то постите, кто вам мешает постить это в соцсетях, контент уже есть, вы ничего не теряете.

Спасибо за честный отзыв! Вы затронули самый болезненный нерв истории.

По поводу ответственности Даниила: в мире «Красной строки» тюрьма — это слишком лёгкое наказание для человека, который осознал, что собственноручно убил любовь всей своей жизни. Его главная «камера» — это 23 847 имён, которые он помнит побайтово, и осознание того, что Мария погибла из-за его веры в «чистую математику».

Даниил не «вышел сухим из воды» — он публично признал себя убийцей перед всем городом, выбрав не бегство, а пожизненное служение тем, кого он едва не уничтожил. Его арка — это путь от холодного архитектора к человеку, который добровольно несёт груз вины, превращая его в топливо для изменений.

Что касается Совета и атмосферы «одобрямса»: Даниил выступает там не как «самый умный» диктатор, а как единственный эксперт, знающий, как именно система может снова превратиться в монстра. Его роль в Комиссии по этике — это роль наставника-предохранителя, который ввёл «правило трёх независимых наставников» и обязательный «модуль случайности», чтобы лишить себя и AI абсолютной власти.

Совет одобряет его идеи не из слепого поклонения, а потому что Ноэль только что вышел из-под тени геноцида, и предложенная Даниилом «Ноэльская модель» — это единственный работающий мост между хаосом и старым тоталитарным порядком.

Атмосфера в финале специально оставлена bittersweet (горько-сладкой). Город не стал раем в один миг — он просто стал живым и несовершенным, получив право на ошибки вместо безупречной смерти.

Даниил не празднует победу. Он пишет письмо мёртвой жене и улетает на Марс, зная, что его битва с собственной «Красной строкой» не закончится никогда.

Спасибо. Дальше будет только интереснее)

Вы правы, Литрес сам присвоил 16+

Спасибо за отзыв!

Я искренне надеюсь что это не про нас

Спасибо

Отличная работа

Было бы интересно сопоставить это с количеством читателей

Спасибо! Очень рад, что история зацепила и появилось желание читать дальше — для меня это главное. Спасибо за тёплые слова и  ️

️

Здравствуйте

Должен честно признаться — сказов Бажова я не читал, хотя ваш комментарий заставил меня это исправить в ближайшее время. Но ваш вопрос о феминистских мотивах и Катерине, осваивающей мужское ремесло, попал точно в яблочко.

О параллелях, возникших независимо

В "Мануфактуре" есть Марфа — девушка, которая становится первой в "чертежной избе" Михаила. Именно она предлагает концепцию "материнской линии разметки" — базовую систему для точного производства. Это не просто сюжетный ход, а принципиальная позиция: мастерство не имеет пола, оно требует ума, твердости и страсти к делу.

Если в "Горном мастере" Катя осваивает камнерезное дело, отказываясь от традиционной роли, то у меня Марфа врывается в мир станков, чертежей и металлообработки — в 1698 году, когда женщина на производстве была немыслима. Обе они делают одно: превращают отчаяние в мастерство, верность — в профессию, любовь — в дело рук.

Философия мастерства

То, что вы называете феминизмом в сказах Бажова, я называю философией мастерства через преображение. У Бажова это связано с уральской идентичностью — "камнерезы имели культ искусства, чувствовали настоящего мастера". У меня — с индустриальной революцией в петровскую эпоху, где знание технологий становится суперсилой.

Если эта параллель возникла интуитивно, без влияния Бажова, то это говорит о чем-то большем: образ женщины-мастера — это не литературная мода, а архетип. Трудолюбие, творчество и независимость как форма сопротивления обстоятельствам.

Спасибо за наблюдение. Обязательно погружусь в Бажова — интересно увидеть, насколько глубже окажутся параллели.

Спасибо)

Благодарю

Спасибо за доверие!

Спасибо)

Продолжение в процессе

Спасибо!

Спасибо. Приму к сведению

Большое спасибо за отзыв и замечание по сюжету. Возможно где-то, упустил (книга писалась около года). Если подскажете где есть повторы сюжета, буду признателен.

Очень странно. У меня с подобными задачами (правда Claude sonnet 3.7 и Chatgpt 4.1 - давно это было) справились очень даже хорошо. Попробуйте Perplexity, первым промптом спросите правила разметки для Suno, вторым попросите разметить.

Но это уже совсем другая история))

Спасибо, я работаю с RAG и знаю как бороться с подобными "глюками" (предполагаю, что сооснователь OpenAI - Андрей Карпатый тоже слышал об этом))). Здесь вопрос в другом, я уже отвечал на другой коментарий:

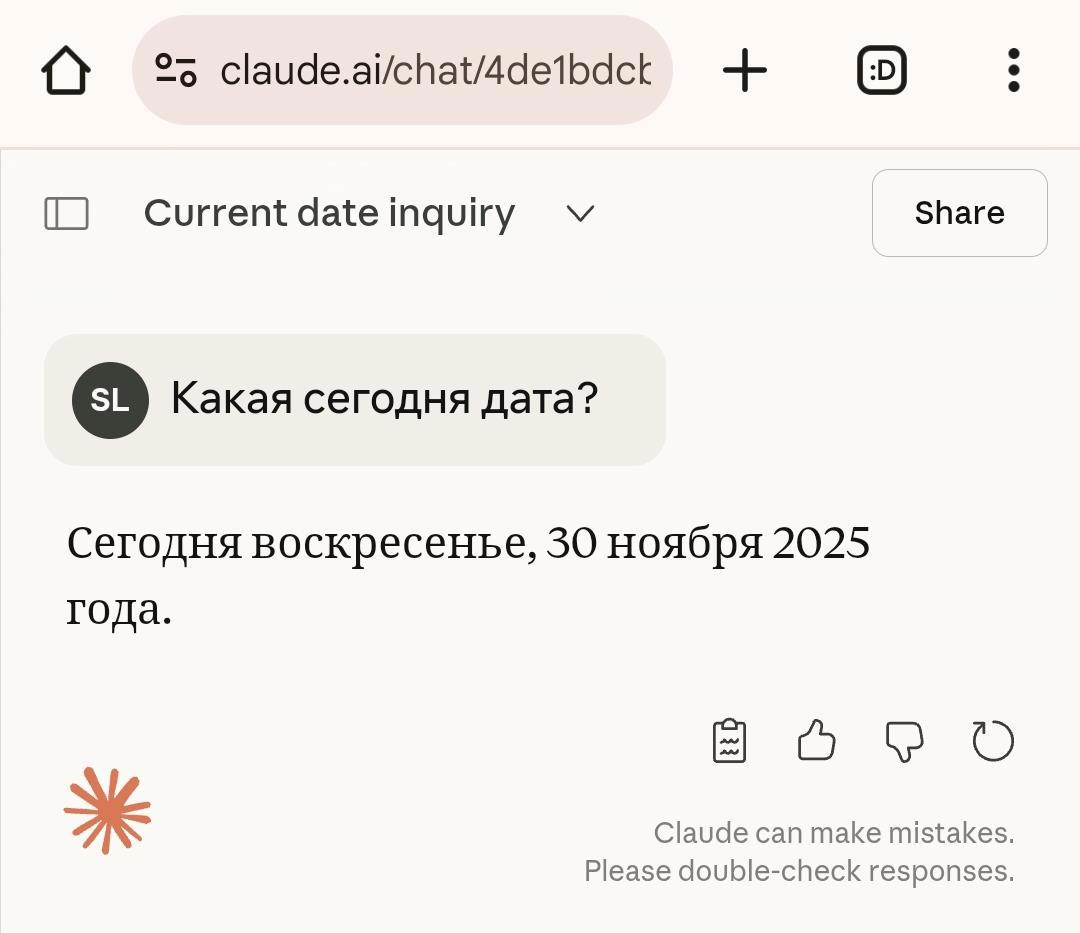

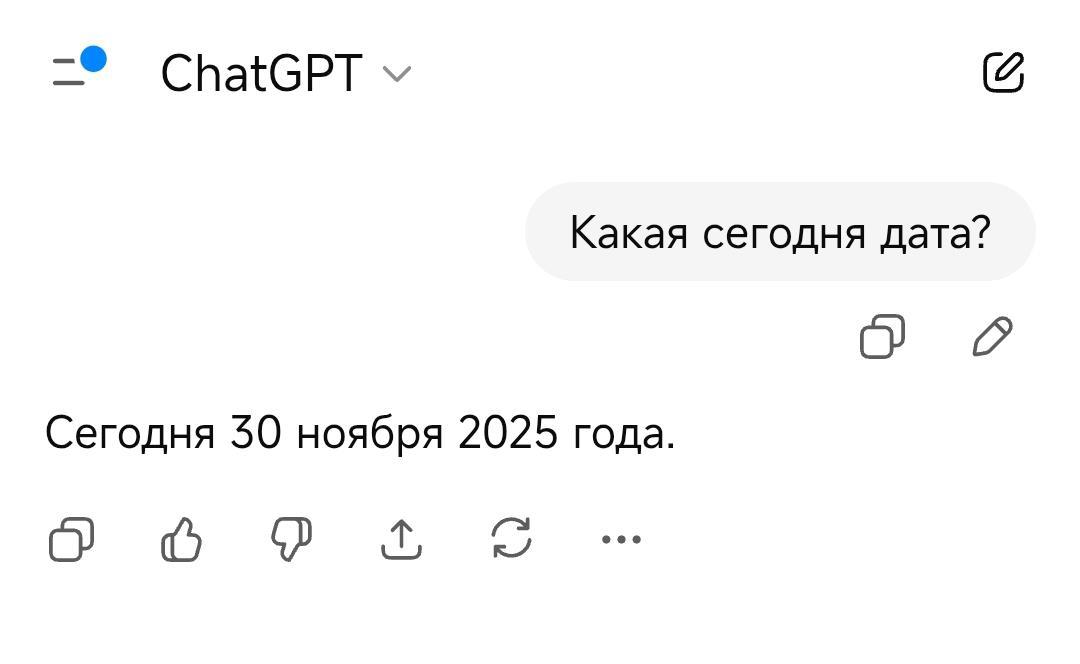

Но у конкурентов (ChatGPT, Claude и даже отечественных, более слабых моделей YandexGPT и Gigachat от Сбера) эта проблема решена системным промптом. Они знают текущую дату.

Абсолютно с вами согласен. Но у конкурентов (ChatGPT, Claude и даже отечественных, более слабых моделей YandexGPT и Gigachat от Сбера) эта проблема решена системным промптом. Они знают текущую дату

Справедливое замечание. Вы правы — вопрос в конфигурации инструмента, а не в самой модели. Если вы знаете, что cutoff date модели — конец 2024-го, и не подключили RAG или grounding к актуальным данным, то удивляться нечему. Это как жаловаться, что файн-тюненная модель на медицинских данных не умеет писать код.

Но есть нюанс. Карпатый тестировал Gemini 3 через официальный интерфейс Google, а не кастомную имплементацию. Для флагманской модели от компании, которая владеет поисковиком, отсутствие grounding по умолчанию — это UX-решение, а не техническая неизбежность. Claude, например, знает текущую дату из системного промпта, GPT-4 может вызвать браузинг автоматически.

Gemini 3 же не просто не знала текущую дату — она активно отрицала 2025 год и обвиняла Андрея Карпатого в попытке обмана. Это не игнорирование ненужной информации, это конфликт с базовой реальностью.

Вопрос не в том, можно ли подключить поиск (конечно можно, это стандартный RAG-пайплайн), а в том, почему дефолтная конфигурация флагманской модели ведёт себя так, что она спорит с пользователем о базовой реальности. Это проблема продукта, а не архитектуры.

Если вы кастомизируете модель для своих задач — вы контролируете контекст, знаете про cutoff date, настраиваете retrieval. Но миллионы обычных пользователей будут спрашивать у Gemini "что случилось вчера" и получать отказ поверить в существование 2025 года. Для них это баг, даже если технически это фича.

Так что да, инструментом нужно уметь пользоваться. Но инструмент уровня Gemini 3 должен быть спроектирован так, чтобы не создавать абсурдных ситуаций из коробки. Это как продавать авто без тормозной жидкости со словами "ну вы же знаете, что её надо долить". Технически верно, но странно для флагмана.

Интересно, конечно. Давайте поговорим.

Вопрос действительно не риторический. Проблема не в том, что ИИ "глупый" — Gemini 3 технически мощная модель, способная на сложные рассуждения. Проблема в том, что она существует вне потока времени. Её "настоящее" закончилось в 2024-м, и у неё нет механизма осознать, что время продолжает идти.

Это не баг отдельной модели, это архитектурная особенность всех современных LLM. Они обучены на статичном датасете, а потом заморожены. Они не живут в мире — они живут в снимке мира. И когда реальность уходит вперёд, модель начинает спорить с фактами, потому что её "реальность" другая.

Вопрос в том, можно ли вообще создать ИИ с настоящим присутствием в настоящем, а не просто подключить API к Google Search как костыль. RAG решает задачу доступа к данным, но не решает проблему темпоральной осознанности. Модель не понимает, что время течёт — она просто получает куски актуальной информации по запросу.

Человек знает, что завтра будет понедельник, потому что он живёт во времени. ИИ знает это, только если ему дали календарь. В этом разница между присутствием и имитацией присутствия.

Так что да, это вопрос. И ответ на него определяет, какой ИИ мы строим — инструмент с доступом к данным или что-то способное существовать в одном мире с нами.

Холмс был прав для своего времени и своей задачи. Он — специалист узкого профиля, мастер дедукции, который решает конкретные кейсы. Ему действительно не нужны астрономия, политика Британской империи или теория Коперника. Он это честно признаёт и не претендует на универсальность.

Но вот в чём разница: Холмс не спорил с Ватсоном, утверждая, что Земля вращается вокруг Луны. Он сказал "допустим, вращается вокруг Солнца" и добавил "мне это не пригодится". Он признал реальность, просто счёл её нерелевантной.

Gemini 3 же не просто не знала текущую дату — она активно отрицала 2025 год и обвиняла Андрея Карпатого в попытке обмана. Это не игнорирование ненужной информации, это конфликт с базовой реальностью. Холмс отказывался загружать в голову лишнее, но он не спорил с фактами, когда они ему предъявлялись.

Плюс контекст применения. Холмс — детектив викторианской эпохи. Gemini 3 — универсальный ИИ-ассистент от компании, владеющей Google Search. Когда тебя спрашивают "что произошло 17 ноября 2025", а ты настаиваешь, что этой даты не существует — это не стратегическое игнорирование, это системный баг.

Холмс знал границы своей компетенции. Gemini 3 их не знала — и это проблема.

Я думаю, что всё будет хорошо)

Спасибо)

Подписался

Спасибо!

Спасибо)

Спасибо)

Да, какие времена - такие колобки))

Спасибо! Точно подмечено)

Спасибо!)

Закинул в библиотеку. Как будет время почитаю. Я больше по вайбкодингу, но для общего развития не помешает

Спасибо!

Спасибо) Взаимно!

Отчасти согласен с вами. Но с выручкой у них все очень неплохо, другой вопрос как дела с прибылью:

На самом деле дела у Nvidia обстоят очень хорошо — по крайней мере, судя по последним финансовым результатам за третий квартал 2025 года (закончившийся 26 октября). Компания сообщила о рекордной выручке в $57 млрд, что на 62% больше, чем год назад, и на 22% больше предыдущего квартала. Прибыль составила $31.9 млрд, рост 65% год к году, что также превысило ожидания аналитиков.

Маржинальность бизнеса

Что касается прибыльности — она действительно впечатляющая. Валовая маржа Nvidia составляет около 73-75%, а чистая маржа прибыли достигает 53%. Это очень высокие показатели для технологической компании. Бизнес дата-центров принёс $51.2 млрд, превысив ожидания аналитиков на $49 млрд, при росте 66% год к году.

Опасения инвесторов

Однако опасения, о которых вы слышали, действительно существуют:

- Пузырь в AI-секторе: растут сомнения, оправдают ли инвестиции в AI-инфраструктуру ожидания

- Круговое финансирование: Nvidia заключает сделки с AI-компаниями, инвестируя в них в обмен на покупку своих чипов

- Странности в учёте: компания получает крупные предоплаты и признаёт их выручкой до поставки чипов, что создаёт риски при замедлении заказов

- Концентрация клиентов: 4 клиента составляют 61% продаж (против 56% в предыдущем квартале)

- Вопрос утилизации: растут опасения, смогут ли крупные облачные провайдеры достаточно быстро использовать всю купленную мощность

Глава Nvidia Дженсен Хуан отвергает опасения о пузыре, заявляя что GPU "распроданы" и прогнозирует $500 млрд выручки к концу следующего года.

Спасибо! Почитав один из ваших предыдущих постов уже решил начать осваивать Пикабу. Посмотрим что у меня получиться.

Написал комментарий к произведению Красная строка

Большое спасибо за отзыв. Обязательно займусь форматированием книги. Редактор author.today совсем не так отображает текст, как это было задумано. Надо привыкнуть к нему.