Анализ длинных текстов через ИИ - пока утопия?

Автор: Мария БерестоваМучаю языковые модели на предмет анализа длинных текстов (от 100 000 символов). Пока что результаты неутешительные, но нашла пару лайфхаков, которые, возможно, пригодятся и вам.

Суть сегодняшнего эксперимента. У меня есть книга в работе, в ней уже 200 000 символов. Она написана от третьего лица, но с позиций главного героя. В книге есть сводный брат главного героя, с позиций которого почти нет текста, он постоянно наблюдаем глазами гг. Всего текста об этом сводном брате примерно 100 000 символов.

Я залила весь текст в ИИ с задачей проанализировать конкретно только линию сводного брата. Абсолютное большинство языковых моделей с этой задачей не справились - объем в 200 000 оказался выше их возможностей.

Я сделала часть работы вручную: в новом файле удалила весь текст, который не касался сводного брата (получив тем самым 100 000 символов) и добавила заголовки и нумерацию эпизодов. Анализ такого подготовленного файла осилили все ИИ. Расскажу, у кого получилось лучше, у кого хуже.

1. ChatGPT (из России не фурычит)

В целом, он честно пытался справиться с целым файлом, но пропустил ряд центральных эпизодов. То есть, сперва он хорошо анализировал начало, потому у него, видимо, закончился ресурс, и он резко перескочил на самый последний эпизод, минуя все, на что ему не хватило памяти. Однако анализ получился хорошим, с опорой на текст.

С доработанным файлом, в котором выделена одна линия, справился без проблем, легко составил и психологический портрет персонажа, и по пунктам перечислил динамику его образа, рассказал, как менялись его чувства и мысли.

Лучше всего работает в анализе конкретных эпизодов. С качественно заданным промтом может анализировать подтекст, вытаскивать наружу то, что в тексте дано намеком.

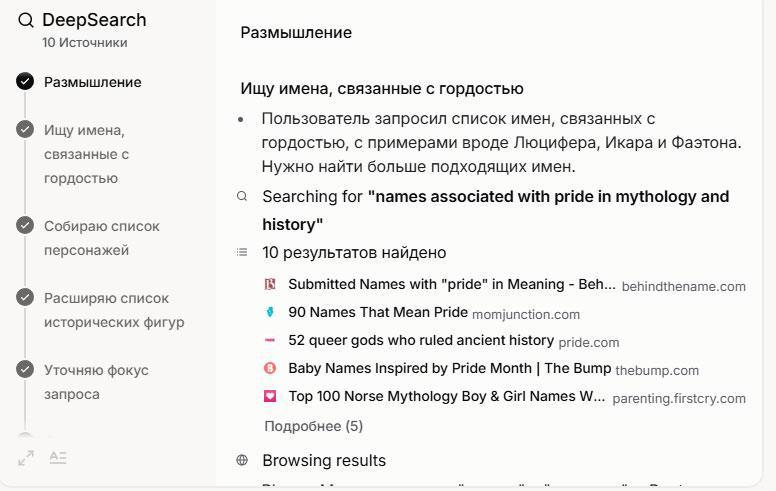

2. DeepSeek

Немного не осилил целый файл, просто произвольно выделил из него кусок, на который его хватило (не с самого начала файла) и честно проанализировал. Опытным путем установлено, что он неплохо анализирует тексты объемом до 150 000 символов. Но, чем больше объем, тем выше вероятность неточностей и прямого вранья.

С доработанным файлом справился отлично (100 000 - в пределах его возможностей). Творчески подошел к моей рубрикации эпизодов: сначала по порядку проанализировал те эпизоды, в которых нужный персонаж является действующим лицом, а в конец перенес те эпизоды, которые я оставила в тексте, хотя перса там не было, но о нем думал гг, и в его мыслях была информация о нем. Вот в этих случаях - где самого перса не было - немного наврал. Эпизоды, где он действует, проанализировал качественно.

На анализе отдельных эпизодов может привирать, и вообще, склонен ко всему подходить творчески, поэтому результат часто удивляет и не вполне удовлетворяет промтам.

3. Грок (из России не фурычит)

И в полном тексте, и в обработанном завис на режиме думания.

В полном тексте, развернув его "мысли", видно, что не осилил весь объем документа и просто завис в какой-то момент. До этого работал над первым этапом - пересказ текста без анализа - так что особой пользы не было.

В обработанном тексте тоже завис, но в "мыслях" видно, что дошел до конца пересказа и начал анализ. Завершить анализ не смог. Но и пересказ, и начало анализа - очень качественные. В отличие от ДипСика, не врет и не сбивается.

Анализ отдельные эпизодов делает великолепно, не хуже ChatGPT.

4. ГигаЧат

При анализе полного текста начал за здравие, да не закончил. Явно прочитал только начало документа, проанализировал его качественно, но представил как полный анализ.

Обработанный текст проанализировал прекрасно. Для каждого эпизода качественно выделил основные чувства и мысли персонажа.

Отлично анализирует конкретные эпизоды.

Это китайский ИИ, презентованный как способный анализировать тексты объемом до 1 миллиона символов, поэтому решила попробовать.

Ну, текст он читает целиком, это правда, но "анализаторка" у него так себе. Эпизоды выделяет странно, комментарии к этим эпизодам сухие и не всегда верные. Путает порядок эпизодов.

Как ни странно, с обработанным текстом лучше не стало. Точно так же путал порядок эпизодов и комментировал их не всегда в тему.

В общем, толку с того, что он "видит" весь текст, особо нет - представить в нормальной форме его анализ не очень-то может.

Мои выводы

Нынешний уровень языковых моделей не позволяет им качественно анализировать текст большого объема. Опытным путем я выяснила, что ChatGPT и DeepSeek неплохо себя показывают в анализе текстов до 150 000 символов, ГигаЧат - до 100 000 символов (с Гроком пока неясно, сколько он может или не может "съесть").

Однако эти лимиты возможно чуть сдвинуть, если провести некоторую ручную работу. В частности, все ИИ немного "помнят" о том, что говорится внутри конкретного чата (эпизодически и с перебоями, но все же), поэтому можно делить текст на отрывки 100-150 000 и анализировать последовательно, либо, как в случае с данным экспериментом, выделять из текста одну линию (требует больше ручного труда).

Помимо "памяти" важным фактором выступают аналитические возможности. Лучше всего как аналитики себя показали ChatGPT и Грок. DeepSeek в режиме "глубокого думания" хорош, но любит приврать, нафантазировать, подойти к задаче "творчески". ГигаЧат тоже показал себя неплохим аналитиком, но я почти его не тестила (опять же, когда-то я тестировала первые версии, которые работали плохо, и пропустила тот момент, когда эту нейросеть допилили до приличного уровня, поэтому только-только включилась в работу с ней).

PS Грок в режиме глубокого поиска - это бомба! Истово рекомендую!