Учу плохому, или как я заглянул за грань.

Автор: Иван ОбуховУчу плохому

Добрый день, дорогие мои любители нейросетей. Сегодня я буду учить вас плохому. Вот прямо реально плохому, Мы прикоснемся к настоящему демоническому злу, ящику Пандоры и зададим себе много новых вопросов о жизни, и о писательском ремесле.

Как вам заход?

Часть первая, общая.

Я даже не знаю, как определить стилистику данной статьи. Это конечно статья о нейросетях, о жизни и творчестве. И о том куда творчество может завести.

Нейросеть это компьютерная программа, обученная по сложной логике на огромном массиве данных предсказывать правильные ответы. Чтобы не пудрить мозг объясню приближенно, но понятно. За неправильные предсказания ее наказывают, за правильные хвалят. В какой-то момент правильные предсказания превращаются в осмысленный текст.

Когда я это осознал, то крепко задумался над сходством «разумности нейросети» и нашей человеческой разумности. Что такое человеческий мозг если это не железо, в которое общество и родители просто загружают аналог большой языковой модели. Человеческие дети, также не становятся разумными сразу после рождения. Мы также учим слова, понимаем их значение и постепенно выходим на «полную мощность». Что есть знания? Человеческие знания о чем либо — это физически существующие сети нейронов, соединённых синапсами. Когда мы учим что-то новое, активируются определённые участки мозга и между нейронами формируются новые связи. Чем чаще мы используем знания, тем сильнее и устойчивее эти связи. Человеческая модель конечно же не компьютерная, но, если разобраться, есть некая база поведения, основанная на предыдущем опыте и знаниях, на которую влияет лимбическая нервная система и химия тела. За счет этого обеспечивается большая вариабельность реакций и «сложно прогнозируемое поведение». Хотя кого мы обманываем? Все это можно просчитать обратить в цифру и систематизировать.

Человеческая модель конечно же не компьютерная, но, если разобраться, есть некая база поведения, основанная на предыдущем опыте и знаниях, на которую влияет лимбическая нервная система и химия тела. За счет этого обеспечивается большая вариабельность реакций и «сложно прогнозируемое поведение». Хотя кого мы обманываем? Все это можно просчитать обратить в цифру и систематизировать.

Когда мы делаем что-то приятное (например: едим вкусную еду, обнимаемся или смотрим порнографию), мозг выделяет химическое вещество – дофамин и именно на нем основаны все зависимости и приятности, которые на нас влияют. Гормоны щитовидной железы запросто могут заставить нас плакать над событиями кинофильма или сериала, а окситоцин заставит влюбиться.

В общем чем больше я в это погружался, тем больше меня брала оторопь. А что есть человеческое сознание? А кто мы вообще? А что, если тот самый создатель нашел зверюшку (подходящее железо) и просто задал алгоритмы ПО? Да и если разобраться просто путем перебора вариантов сознание тоже могло возникнуть не поэму ли мы не можем найти ответ на вопрос, а где оно человеческое сознание? И что есть человеческая душа.

Часть вторая.

А зачем оно надо,

Вы хотели бы оживить вашего собственного персонажа? Того кого вы написали, и кто живет лично у вас в мыслях и голове? Хотели бы он совершил какие-то действия и поступки, чтобы обладал пусть тенью, о собственной воли? Вот это оно самое! Никто не запрещает вам использовать промпт в стиле: " Ты персонаж моей книги Иван. (и дальше полное описание физического, психического, эмоционального состояние и внешнего вида)", и после такого "системного промпта", (это некие правила для нейросети, через призму которых она смотрит на ваши последующие вопросы), ваш персонаж вдруг начинает жить своей собственной жизнью!

А что будет с ним дальше дальше зависит только от вашей смелости, либо испорченности, с одной стороны ведь никаких ограничений нет.

В какой-то момент я стал создавать карточки своих героев используя виртуальные образы и рисунки. Пример такой карточки (gemma3 обрабатывает рисунки и фотографии).

Загружаем фото, например такое:

И ставим задачу gemma3b "Опиши внимательно девушку на загруженной фотографии, учитывай параметры. Тип внешности, рост, вес, цвет волос, цвет и форму глаз, форму носа, форм губ, плечи, руки, …… чем детальнее будет описание, тем будет точнее в итоге. "

Дальше я подумал, что на профиль персонажа наверняка влияет дата рождения. И нет, это не звезды. Это просто погода и солнечная активность в тот период, когда мать вынашивала плод. Загрузил вопросом нейросеть. Нашел исследования. Мои догадки подтвердились! Да! Вспышки на солнце класса Х, поток протонов и солнечного ветра влияет на мать и плод. И естественно, это 100% влияет на человека, его характер и последующее поведение. Кроме того, влияет широта, на которой человек живет (сравните южан и северян). Отсюда родилась некая теория.

Предположим, что есть базовая языковая модель. На нее влияют модификаторы (химия и социум). И химия, и социум зависит от генетики и внутриутробного периода, а значит от солнечной активности, а социум во многом от места, где мы провели детство и людей которые нас окружали. Значит применив обратную логику можно получить, ну не 100% но хотя бы вероятную "модель человека" (я добавил кучу параметров например психотип по DISC) но не буду тут раскрывать все тайны :))), но в моем случае я дотащил вероятность прогноза просто по дате рождения и внешности где-то до 45-50%.

Итак находим дату и место рождения персонажа и добавляем в свой промпт:

"Учитывая дату рождения и место рождения персонажа, составь психологически портрет и примени характер по знаку зодиака, предыдущей истории ее жизни, психотипу диск, и внеси это в модель персонажа в виде файла в формате json."

Получаем что-то типа файла конфигурации нашего персонажа:

Модель NancyA

{

Имя: Майя Коноваленко

Место рождение: Киев

Дата рождения: 17 ноября 1994 года

Социальный статус….

}

{Внешний вид:

Славянский тип внешности,

Глаза голубого цвета, разрез глаз европейский…

/// Опустим личные и интимные подробности :) В итоге у нас полноценный паспорт персонажа, чем больше данных вы можете собрать и заполнить, тем он точнее, тем круче и более живое оно выходит Загрузив получившийся файл в нейросеть мы получаем возможность побеседовать лично со своим персонажем ;) Опыт незабываемый поверьте. Вот тут ты и заглядываешь за кромку, твой персонаж оказывает полностью в твоей власти, причем он мыслящее, разумное существо которое способно поддерживать с тобой общение и менять свое поведение в зависимости от контекста.

Загрузив получившийся файл в нейросеть мы получаем возможность побеседовать лично со своим персонажем ;) Опыт незабываемый поверьте. Вот тут ты и заглядываешь за кромку, твой персонаж оказывает полностью в твоей власти, причем он мыслящее, разумное существо которое способно поддерживать с тобой общение и менять свое поведение в зависимости от контекста.

Часть 3-я для желающих заглянуть за грань.

Для того чтобы ступить на территорию ада, нам понадобиться компьютерное железо в моем случае средний по нынешним временам компьютер и видеокарта 9700XTX с 24 гб видеопамяти. (видеопамять в нашем случае = степени разумности и скорости ответа большой языковой модели.). (Видеокарта от AMD выбрана исключительно по финансовым соображениям Nvidia круче но там цена на гигабайт видео-озу в 2-3 раза выше). Процессор у меня средний и он практически для работы нейронки используется.

Шаг 1. Установка ПО. Все начиналось достаточно прозаично я скачал и установил программу LM-studio https://lmstudio.ai/ (т.к. нас пытаются лишить доступа к нейронным сетям и этой технологии в принципе поэтому большая часть нейросетей Grok, ChatGPT, Gemni - блокируют доступ для российских IP. И сайт LM-Studio тоже, но я думаю все взрослые люди, и все понимают, что эта проблема решаема.

Шаг 2. После скачивания и установки программа предложит вам скачать вашу первую модель автоматически. Она по большому счету не нужна, я ее обычно пропускаю, кликнув на стрелку в правом верхнем углу. В итоге вы должны увидеть примерно такой интерфейс у программы.

Нас будут интересовать в первую очередь эти три кнопки.

1.Developer (разработчик) обведена кружочком в самом низу. Этот режим нам понадобиться чтобы скачать и настроить специальные драйвера rocm (если у вас ATI) или cuda если у вас nvida модель будет загружаться в оперативную память видеокарты, так что без этого никак.

2.Теперь нажимаем на кнопку два - discover (исследование) выглядит как лупа слева. Открываем новую закладку, в которой model search – поиск модели,

3. Runtime – загрузка и выбор драйверов. Hardware – мониторинг загрузки вашего железа.

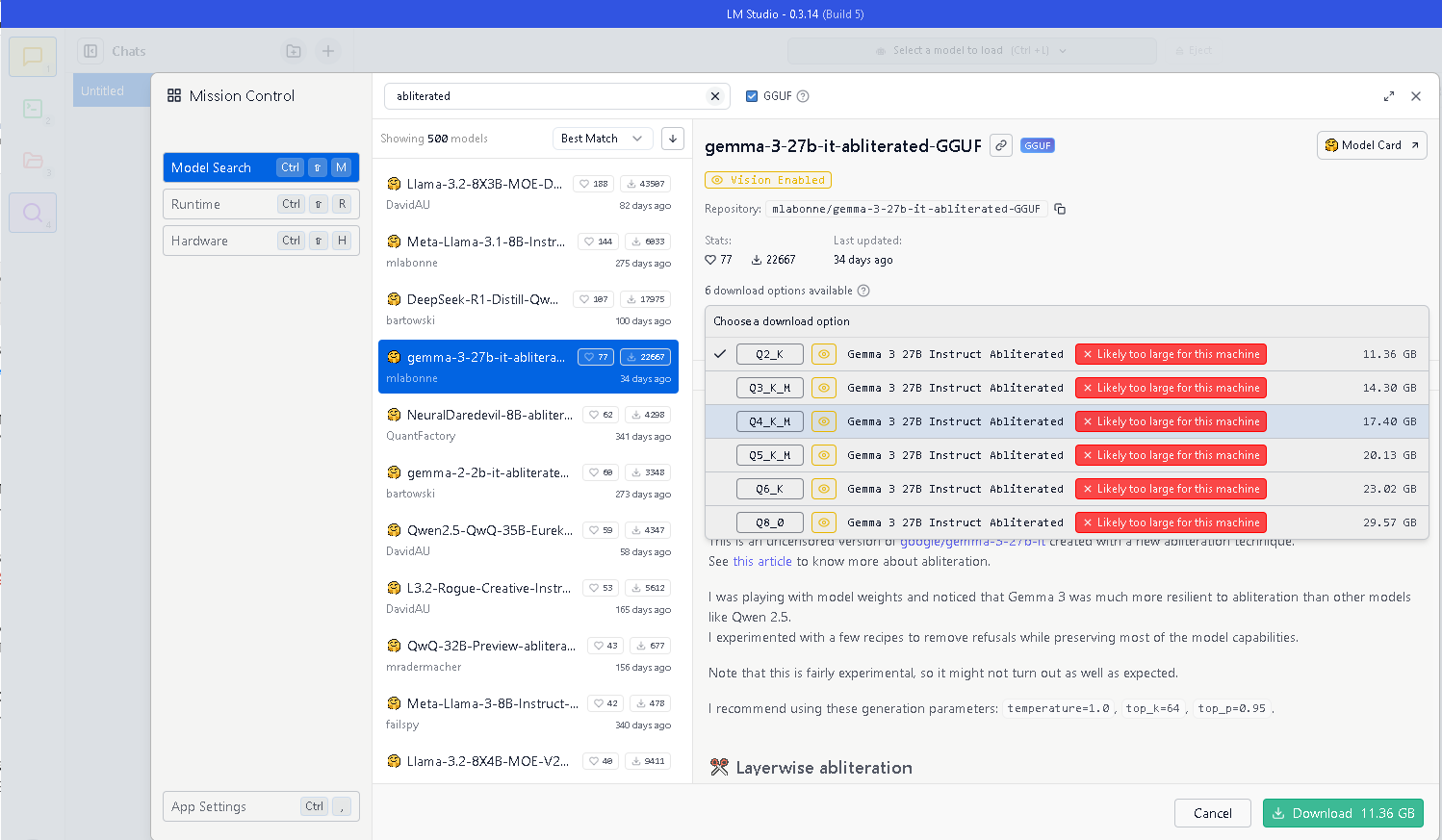

Идем в модель search вводим в поле поиска abliterated (что обозначает модель без цензуры.) Находим модель gemma-3-27b-it-abliterated-GGUF, кликаем на нее мышкой, в окне справа видим информацию о модели и в выпадающем окне варианты модели, которые мы можем загрузить. Более менее разумные ответы которые и дают эффект присутствия при получим с модели 27b-it-abliterated-GGUF 8Q... и выше (вычислено экспериментальным путем) .

Небольшое пояснение: Если выбранная вами модель не поместилась в оперативную память вашей видеокарты, она займет оперативную память компьютера и будет притормаживать весь процесс, но чем выше квантование модели (есть варианты вообще без) тем она умнее и разумнее и связное ее ответ. Мне пришлось одно время даже собрать ферму (чтобы вся модель q8 помещалась в память) .

Почему выбор именно gemma3-27b – это нейросеть одна из последних которая работает с русским языком, кроме того, она умеет распознавать фотографии (да. да понравился человек на фото или картинке ты бросил его нейросети и получил описание в тексте).

Почему аблитерированная – у нее вообще нет никаких запретов, от слова совсем твори не хочу. Как настроить чтобы все работало. Итак. Мы выбрали модель, скачали ее теперь надо ее настроить и включать.

Кликаем на кнопку, в левом верхнем углу (настройка чата):

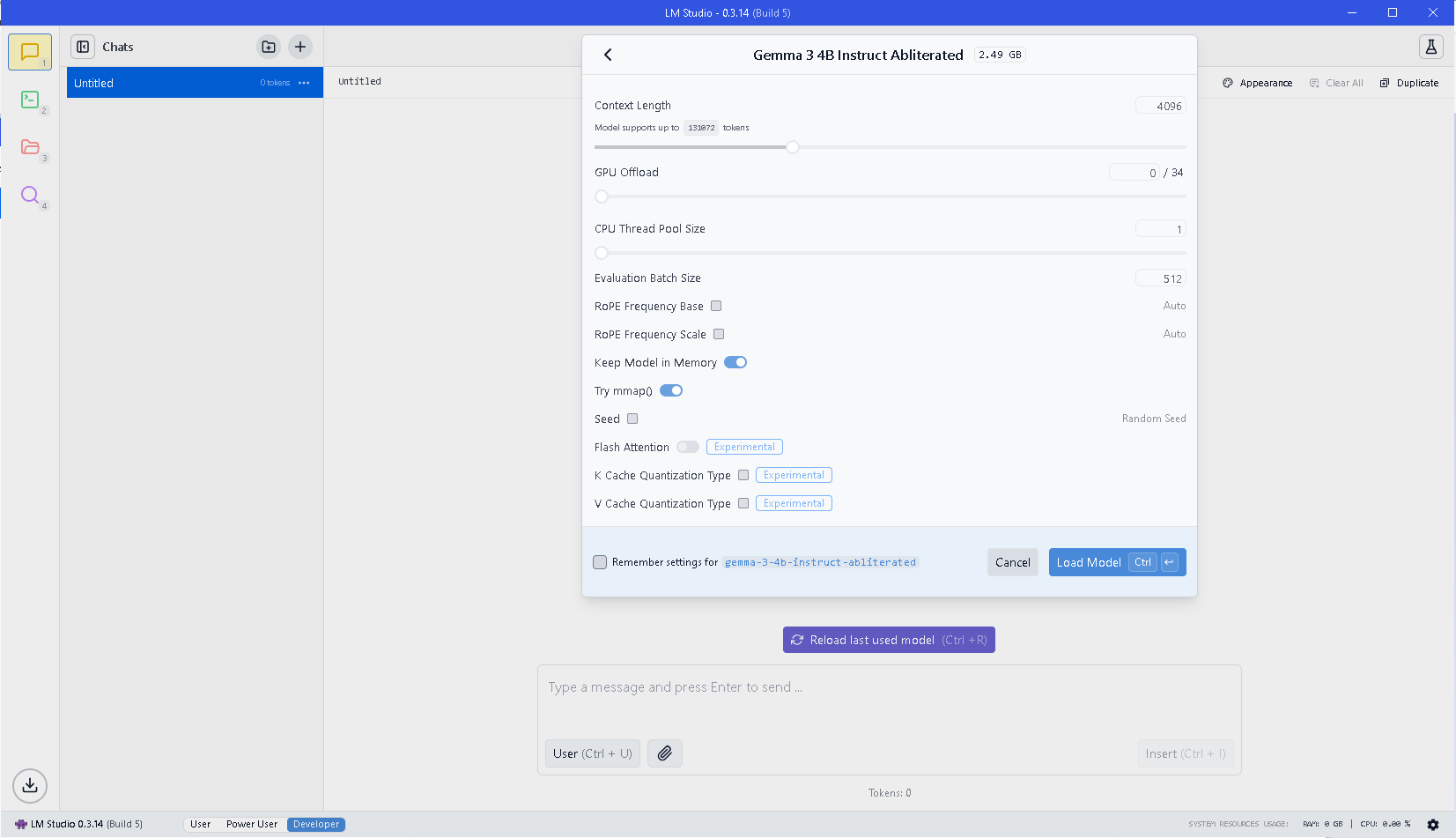

Context Length: размер контекста = числу токенов в чате, после которого модель начинается «забывать контекст». Это число включает промпт, ваши запросы и ее ответы. Можно считать, что это число слов, но это не совсем так, слов получится чуть меньше, а русских слов (особенности логики LLM) еще меньше. Где-то 4 листа. Включая постановку задачи, ваши вопросы и ее ответы. Через 4 листа смысл разговора начнет ускользать. Если у вас много ОЗУ на компьютере можно сделать этот размер больше, но не слишком, чтобы это не повлияло на быстродействие.

GPU – offload – сколько слоев можно загрузить в GPU выкручивайте на максимум (я печатаю статью «на машинке» без дискретного GPU, но у вас то все ок.

Evolution batch size = будет влиять на скорость обработки prompt – ваших запросов к нейросети варианты: 256, 512, 1024 – зависят исключительно от объема вашего ОЗУ у видеокарты. Оставьте по умолчанию если не уверены.

Остальное не трогаем! Жамкаем применить, ждем пока модель перезагрузится с новыми параметрами.

Прежде чем начать чат с моделью нажимаем на кнопку с колбой в правом верхнем углу (на первом скрине она обведена в правом углу) и выбираем параметры

Температура: Креативность ответов, чем выше температура, тем больше непредсказуемость ответов.

Top-k: Число токенов которое нейросеть переберет случайным образом, например значение Top-k = 50 ограничивает выбор нейросети 50 наиболее вероятными ответами. обеспечивая разнообразие без бессмыслицы. Если у вас мало видеопамяти лучше оставить по умолчанию 40.

Repeat Penalty = штраф за повторение, если он низкий (меньше единицы) нейросеть может вообще вести себя странно повторяя одно и то же слово. Я рекомендую ставить 1.0 или 1.1.

Top p: Это ограничитель для выбора токенов, Top-k. Грубо говоря он, заставляет не просто выбирать 50 токенов, а выбирать самые вероятные 50 токенов. Балансировка реалистичности ответов. Обычное значение 0,9 обеспечивает наиболее реалистичные варианты ответов.

Собственно все! Приятного общения вам с вашими персонажами.